Риски техногенных катастроф нарастают

Мы летаем самолетами, храним жизненно важные данные, наращиваем атомную энергетику, несмотря на уязвимости критически важной ИТ-инфраструктуры и уповая на частичное резервирование критических подсистем. И мы начали передавать машине принятие комплексных решений.

Техногенные риски — не столько затягивающаяся экспериментальная фаза освоения технологии, сколько тупиковая управленческая ситуация. Природа тупика — асимметричность информации и ресурсов. Ну как, скажите, надежно договориться ученым, юристам, правительствам, бизнесам со столь разными интересами и пониманием самого предмета! При том, что у кого-то больше ресурса, а у кого-то агрессивные помыслы. Тем временем разработчики продолжают создавать технологии, а бизнес и государства соревнуются во внедрении, хоть и опасаясь, но игнорируя возможные побочные эффекты.

Стратегия в отношении крайне маловероятных фатальных событий: «живем и надеемся на лучшее»

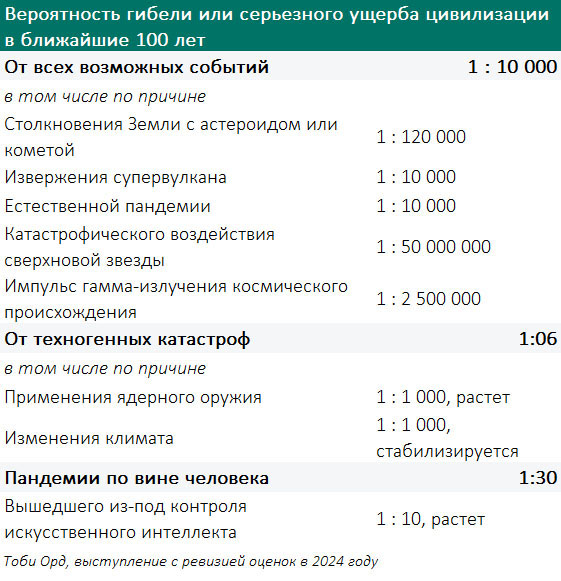

За последние 20 лет в научной повестке распространился термин «экзистенциальные риски» — те, что угрожают самому существованию человечества. Думаю, об этих рисках говорят много больше, чем они того заслуживают. Какой смысл готовиться к фатальному извержению супервулкана, коих на Земле, включая Камчатку, два десятка, или столкновению с небесным телом? Подобные события маловероятны. Согласно расчету Жан-Марка Салотти, вероятность гибели цивилизации в 21 веке — 1 из 30 миллионов, а по оценке Тоби Орда, наиболее цитируемого исследователя экзистенциальных рисков и восприятия их людьми, — 1 из 10 тысяч.

Ядерная война? Чемоданчик находится в руках ограниченного числа людей, которые за пределами влияния обывателя.

Экологическая катастрофа? Развивается медленно, поэтому прохождение «точки невозврата» мы, скорее всего, не заметим.

Прекратить животноводство, вырубку лесов и сбросы в океан? Но в потребление и производство, предположительно вредного для природы, вовлечены миллиарды людей.

Результативно ли тратить энергию на предупреждение неуправляемых маловероятных фатальных угроз? Здесь нередки дискуссии об этической стороне, например, об обязательствах перед будущими поколениями. Рыночный механизм дает эффективное, но негуманное решение в отношении фатальных угроз, и он практически не позволяет учесть интересы следующих поколений. Значит, нужна добрая воля на уровне мировых центров сил. Реалистично ли?

Стратегия в отношении нефатальных рисков: «предотвращаем и приспосабливаемся»

Большего внимания заслуживают события нефатальные, которые грозят лишить ныне живущие поколения возможности достичь желаемого будущего.

В отношении таких угроз реалистично скоординироваться, достичь договоренностей и контролировать их соблюдение. В сфере разработки и внедрения искусственного интеллекта, биологических и генных исследований, атомной энергетики число лиц, принимающих критические решения, сравнительно невелико — несколько сотен. В большинстве случаев возможно идентифицировать авторов, повлиять на триггеры, первопричины цепочек событий. Следовательно, поставить в приоритет предупреждение, нежели устранение последствий.

В анализе Тоби Орда возможность техногенных катастроф уже 1 к 6. Наиболее вероятной угрозой названы события, которые могут быть спровоцированы искусственным интеллектом.

Пять сценариев, что может пойти не так.

- Все идет по заданной программе, но из-за недостаточности знания, оперативной информации, возникновения непредусмотренной алгоритмом ситуации возникли побочные разрушительные эффекты.

- Авария произошла из-за того, что создатели системы или лица, принимающие решения, ошиблись в проектировании системы, создании алгоритма.

- Система автоматизации работает согласно установке, но совершает фатальную ошибку или выходит из строя, что и становится причиной катастрофы. Чернобыль, Фукусима и Бхопал, химзавод в Индии, — иллюстрации в тему. До сих пор нет однозначного мнения, какой из трех перечисленных выше сценариев имел место в каждом случае.

- Преднамеренный ущерб: лица, принимающие решения, задают установку, которая приносит ожидаемый результат для «своих», но разрушительный для другой части человечества. Это сценарий большинства экологических катастроф.

- Система начала действовать разрушительным образом по своему усмотрению, то есть вопреки установке. Это уже про искусственный интеллект будущего, который выйдет на передний план через 5-10 лет.

Надо привыкнуть с этим жить. Строить личные и корпоративные планы. Инвестировать. И, если говорить про бизнес, заложить готовность к техногенной катастрофе в стратегию.

Риски, заложенные в стратегию бизнеса

Возьмем за пример развитие атомной генерации в сейсмоопасном регионе или транспортировку нефти в заполярье. Риски понятны. Должен ли хозяин проекта браться за такого рода бизнес? Почему бы и нет, если он намерен инвестировать в развитие сейсмоустойчивых решений, локализации и ликвидации разливов в условиях полярной зимы, если он имеет доказательную базу прибыльности дела.

Но смотреть стоит масштабнее и сопоставить стратегические альтернативы, выходящие за рамки одного бизнеса. Возможно, заказчику атомной генерации или заполярной транспортировки нефти следует включить в свою повестку стратегические альтернативы из смежных сфер бизнеса: девелопмента, ИТ и автоматизации, науки. Если концентрация потребителей энергии — жителей и производств, — окажется обоснованной, тогда да, однозначно беремся. И не беремся, если найдется более дешевая и надежная альтернатива федерального масштаба. Не должно ли государство поддержать создание общественных организаций для координации подобного взаимодействия? Есть ли для этого механизмы и добрая воля?

Во многом нам придется импровизировать. Опереться на исторический опыт полезно, но недостаточно. Фукусима, платформа в Мексиканском заливе, химзавод в Бхопале, прорыв плотин в Хэнани — при всей трагичности эти события остались локальными и не привели ни к масштабным банкротствам, ни к переделу рынков. Что стало триггером, какие изменения в технологии были введены, — все это заслуживает изучения, но бизнесу, ученым и государствам предстоит создавать новые правовые нормы и механизмы реагирования, более адекватные инструменты мониторинга.

Единственный близкий к глобальному масштабу прецедент — коронавирусная пандемия, которую можно классифицировать как техногенную, потому что системы оповещения и защиты не сработали как надо, допустив ее глобальное распространение. Главный урок событий 2020-21: готовность быстро изменить привычный образ жизни — необходимая часть любого плана «Б».

Возможно, конкретный человек, компания или государство сумеет уменьшить для себя масштаб последствий в случае наступления подобного события. Но, как ни готовься, техногенные риски с нами навсегда. С ними придется жить, осознавая неизбежность этой самой Одной Шестой. Развернуть ситуацию, научившись договариваться в интересах неродившихся и потому не имеющих голоса поколений, — это сверхзадача, в решении которой человечество пока не преуспело.